Spark大數據技術與應用 數據處理技術的核心開發實踐

隨著數據量的爆炸式增長,傳統的數據處理框架已難以滿足海量、高速、多樣數據的分析需求。Apache Spark作為一種開源、通用、高效的大數據處理引擎,憑借其卓越的內存計算能力、豐富的API支持及靈活的部署方式,已成為現代大數據技術棧中的核心組件。本文將探討Spark在數據處理技術開發中的關鍵應用與實踐。

一、Spark技術架構與核心優勢

Spark的核心架構基于彈性分布式數據集(RDD)和統一的數據抽象層,提供了批處理、流處理、機器學習、圖計算等多種計算模型。其核心優勢主要體現在:

- 內存計算:通過將中間數據存儲在內存中,顯著減少磁盤I/O,使迭代計算和交互式查詢性能提升數十倍。

- 統一開發棧:Spark SQL、Spark Streaming、MLlib(機器學習)、GraphX(圖計算)等組件共享同一API和運行時環境,簡化了開發流程。

- 容錯性高:基于RDD的血緣(Lineage)機制,無需數據復制即可實現高效的容錯恢復。

- 易用性與兼容性:支持Java、Scala、Python和R語言,并能與Hadoop HDFS、Hive、Kafka等大數據生態無縫集成。

二、數據處理技術開發中的關鍵應用

1. 批處理與ETL開發

Spark Core和Spark SQL為大規模數據批處理提供了高效解決方案。開發者可通過DataFrame和Dataset API進行結構化數據的ETL(提取、轉換、加載)操作,例如數據清洗、格式轉換、聚合統計等。代碼示例如下(使用PySpark):`python

from pyspark.sql import SparkSession

spark = SparkSession.builder.appName("ETLExample").getOrCreate()

df = spark.read.csv("hdfs://path/to/data.csv", header=True)

dfclean = df.filter(df["age"] > 18).groupBy("city").agg({"income": "avg"})

dfclean.write.parquet("hdfs://path/to/output")`

2. 流處理與實時計算

Spark Streaming和Structured Streaming支持高吞吐、低延遲的實時數據處理。適用于日志分析、實時監控、在線推薦等場景。開發者可通過微批(Micro-batch)或連續處理模式處理Kafka、Flume等數據源的數據流。

3. 機器學習與數據挖掘

MLlib提供了豐富的機器學習算法(如分類、回歸、聚類)和特征工程工具。結合Spark的分布式計算能力,可在海量數據上快速訓練模型,支持從數據預處理到模型部署的全流程開發。

4. 圖計算與復雜分析

GraphX提供了圖并行計算API,適用于社交網絡分析、路徑規劃、風險傳播模擬等需要處理復雜關聯關系的場景。

三、技術開發最佳實踐

- 性能優化:合理設置分區數、利用廣播變量減少數據傳輸、通過緩存(cache/persist)復用中間結果、選擇高效的序列化格式(如Kryo)。

- 資源管理:根據集群配置動態調整Executor數量、內存分配及并行度,避免資源浪費或OOM(內存溢出)錯誤。

- 代碼可維護性:采用模塊化設計,結合單元測試(如使用Spark Testing Base)確保邏輯正確性,并利用日志監控作業運行狀態。

- 生態整合:結合Delta Lake實現ACID事務支持,或通過Apache Airflow調度Spark作業,構建端到端的數據管道。

四、未來趨勢與挑戰

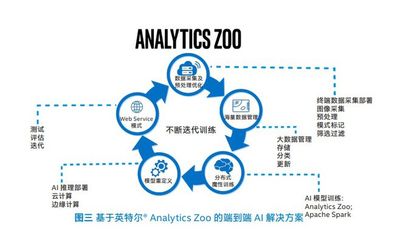

隨著云原生和AI驅動的數據分析需求增長,Spark正持續演進:

- Spark on Kubernetes:提升容器化部署的彈性與資源利用率。

- 與AI框架融合:加強與TensorFlow、PyTorch的集成,支持深度學習任務。

- 實時性深化:Structured Streaming持續優化,向更低延遲的事件時間處理發展。

開發中仍需應對數據傾斜調優、小文件處理、多租戶安全等挑戰。

###

Spark以其強大的生態和持續創新,已成為大數據處理技術開發的事實標準。開發者需深入理解其內核原理,并結合業務場景靈活運用,才能充分發揮其潛力,構建高效、可靠的數據處理系統。從批處理到實時分析,從機器學習到圖計算,Spark正推動著數據驅動決策的邊界不斷擴展。

如若轉載,請注明出處:http://m.ckotq.cn/product/44.html

更新時間:2026-01-07 19:36:19